Absicherung von KI-basierten Systemen

Das safeAI-Team der IABG entwickelt Lösungen für die Evaluierung und Prüfung von KI-basierten Systemen, um eine zukünftige Konformitätsbewertung zu ermöglichen.

Wir kombinieren die neuesten Erkenntnisse aus KI-Forschung, -Standardisierung und -Regulierung mit der langjährigen Erfahrung der IABG auf den Gebieten Test-, Analyse- und Zertifizierungsprozesse. Durch unsere aktive Beteiligung in nationalen, europäischen und internationalen AI-Standardisierungsgremien unterstützen wir die Entwicklung neuer Standards und Richtlinien, um den Nutzen von KI-Systemen zu steigern. Mit der Initiierung der DIN SPEC 92005, "KI-Quantifizierung von Unsicherheiten im maschinellen Lernen", leisten wir dazu einen grundlegenden Beitrag.

Kontaktieren Sie uns, um mehr über unsere Aktivitäten und Möglichkeiten der Zusammenarbeit zu erfahren. Wir freuen uns darauf, gemeinsam mit Ihnen einsatzfähige und vertrauenswürdige KI-Technologien zu entwickeln.

Dimensionen der Bewertung von KI-Sicherheit

Dataset

Die Analyse der zugrunde liegenden Daten eines KI-Modells untersucht, wie ausgeglichen und repräsentativ diese für den spezifischen Anwendungsfall sind. Zusätzlich werden Schwachstellen oder unterrepräsentierte Datenpunkte identifiziert, um eine optimale Leistungsfähigkeit des Modells zu gewährleisten.

Performance

Bei der Bewertung der Leistungsfähigkeit des KI-Modells werden anwendungsspezifische Metriken berechnet, mit denen bestimmt werden kann, wie effektiv das Modell seine vorgesehene Aufgabe erfüllt. Dies gibt Aufschluss darüber, ob und unter welchen zusätzlichen Sicherheitsmaßnahmen das Modell sicher und zuverlässig eingesetzt werden kann.

Uncertainty

Unsicherheit ist ein wesentlicher Bestandteil jeder KI-Anwendung, jedoch wird sie nicht von allen Modellen berücksichtigt. Korrekt quantifizierte Unsicherheiten können genutzt werden, um zu beurteilen, ob Vorhersagen vertrauenswürdig sind und somit zu einer besseren Entscheidungsfindung und erhöhter Sicherheit führen.

Robustness

Die Robustheitsbewertung untersucht, ob die Leistungsfähigkeit des KI-Modells erhalten bleibt, wenn verschiedene Arten von Eingabestörungen auftreten. Der sichere Einsatz eines Modells kann nur dann gewährleistet werden, wenn es robust ist gegenüber verschiedenen und wechselnden Umwelteinflüssen.

Explainability

Der sichere Einsatz eines KI-Modells und seiner Entscheidungen verlangt die Nachvollziehbarkeit und Interpretierbarkeit der Ergebnisse. Durch die Berücksichtigung der Erklärbarkeit des Modells werden Vorhersagen und Entscheidungen transparent und nachvollziehbar.

Compliance

Compliance bezieht sich auf die Einhaltung von Anforderungen und Regelsätzen für die Entwicklung und Nutzung sicherer und vertrauenswürdiger KI-Systeme. KI-Standards spezifizieren dabei Anforderungen, die sich auf die Evaluierung von KI-Modellen als zentralen Bestandteil des Compliance-Prozesses beziehen. Die Regelsätze werden durch Regulierungen wie den European AI Act sowie die KI-Standards festgelegt.

safeAI in Action

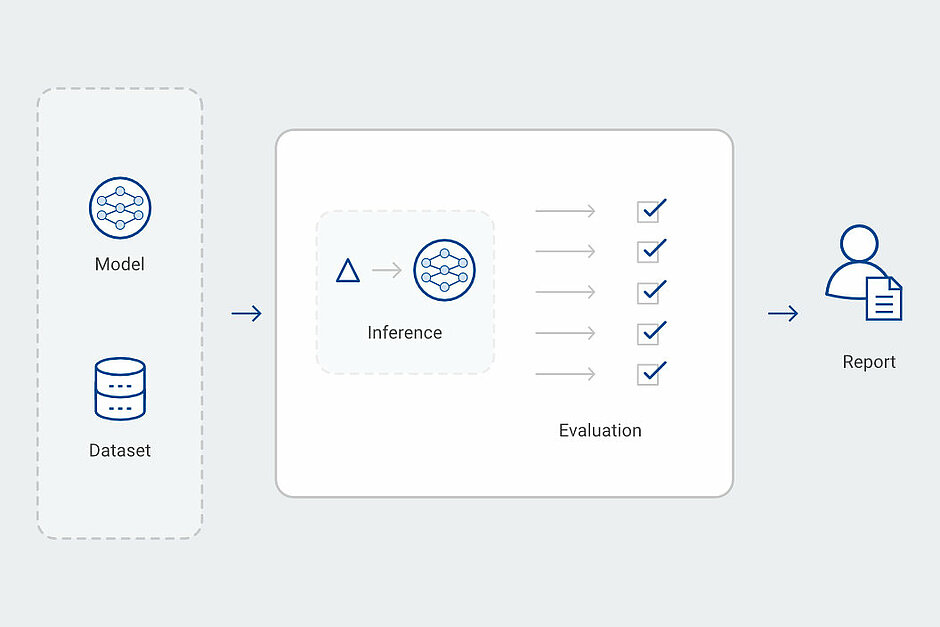

KI Evaluations-Workflow

Die Bewertung der Sicherheit und Zuverlässigkeit eines KI-Modells und seines zugrundeliegenden Datensatzes benötigt eine Evaluierung hinsichtlich verschiedener Aspekte in einer dafür geeigneten Infrastruktur.

Software/Hardware Integration

Die Integration von KI-basierten Softwarekomponenten in ein cyber-physisches System erfordert umfangreiche Tests in virtuellen und realen Umgebungen, um zu erproben, dass dieses sicher eingesetzt werden kann.

Generierung Synthetischer Daten

In fotorealistischen Simulationsumgebungen können Datensätze für das Training und die Evaluierung von KI erzeugt, gelabelt und augmentiert werden.